Che viene genericamente etichettata come Intelligenza Artificiale ,(IA), Generativa

Ma è l’ultimo figlio di una schiera di software ed ha un nome specifico

ChatGPT

Ho seguito , da poco tempo, questa vicenda con un atteggiamento inizialmente di sano ed umano scetticismo derivante dalla lunga ed antica storia di confronto tra la misura delle umane possibilità ed il desiderio di trascenderne la natura con l’intelligenza, il coraggio e la forza e tanta letteratura e filosofia hanno sottilmente e quasi sempre inconsapevolmente alimentato il mito ed il desiderio dell’uomo di emanciparsi dagli arcaici strumenti di forza e coraggio e di privilegiare piuttosto l’intelligenza per il dominio ed il controllo sulla natura per affrontare la perenna sfida della sopravvivenza.

Credo che oggi con gli ultimi sviluppi dell’ Intelligenza Artificiale ,(IA), Generativa si possa dire che un epoca nuova stia delineandosi all’orizzonte in cui il fattore “INTELLIGENZA” nella sua forma non umana, quindi “ARTIFICIALE”, sia prevalente come fattore strategico di forza e dominio.

È un orizzonte con uno scenario in cui le promesse di sviluppi positivi è intrecciato con problematiche socioeconomiche ed etiche estremamente complesse e preoccupanti e pertanto ognuno dovrà farsi carico di capire, nella misura in cui è possibile, le problematiche generali e tecniche di questi sviluppi scientifici .

Già sento le solite litanie che enunciano la incommensurabile distanza fra l’intelligenza umana e quella artificiale ed è sicuramente vero che OGGI la ricchezza e la forza intellettuale ed emotiva degli esseri umani è molto al di sopra degli ultimi prodotti dell’IA , ma è come confrontare le sorti delle guerre, e quindi dell’umanità, prima e dopo l’invenzione della polvere da sparo. La polvere da sparo, come è facile intuire, cambiò il modo di far la guerra così come oggi il lavoro, la medicina, il controllo sociale ed il modo di fare la guerra e quasi tutti gli aspetti delle attività umane stanno cambiando con l’uso dell’IA .

Salteremo l’analisi storica degli sviluppi dell’IA che possiamo trovare dovunque e passeremo ad analizzare le tematiche tecniche con cui funziona , in particolare vedremo come funziona una rete neurale e come si realizza questo dialogo tra il sottoscritto e CHATGPT al quale chiedo di spiegarmi come funziona quando riconosce un immagine o come riesce a “CAPIRE” le mie domande.

Le mie domande sono stringhe di testo così come le sue risposte ma solo perché uso una versione non a pagamento mentre in realtà le versioni più avanzate interagiscono con gli umani anche attraverso la vista e l’udito, i moderni robot utilizzano anche il tatto e, da qualche parte si sperimenta sul gusto e l’olfatto.

Come campo dell’informatica, l’intelligenza artificiale comprende ed è spesso menzionata insieme al machine learning e il deep learning. Queste discipline prevedono lo sviluppo di algoritmi di AI, modellati sui processi decisionali del cervello umano, che possono “imparare” dai dati disponibili e fare classificazioni o previsioni sempre più accurate nel tempo.

Il machine learning e il deep learning sono sottodiscipline dell’AI

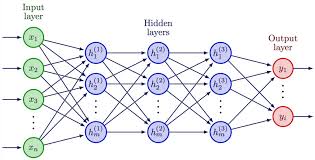

Sia il machine learning che gli algoritmi di deep learning utilizzano le reti neurali per “imparare” da enormi quantità di dati. Queste reti neurali sono strutture programmatiche modellate a imitazione dei processi decisionali del cervello umano. Sono costituite da strati di nodi interconnessi che estraggono correlazioni dai dati e costruiscono modelli interpretativi su ciò che i dati rappresentano.

Machine learning e deep learning si differenziano per i tipi di reti neurali utilizzati e per la quantità di intervento umano richiesto. Gli algoritmi di apprendimento automatico classico utilizzano reti neurali con un strato di input, ovvero i valori che un sensore ha misurato, quindi ci sono due o più strati “nascosti” dove avviene un complesso processo matematico di elaborazione di questi dati ed infine uno strato di output dove si esplicita l’interpretazione di questi dati. Vedremo in dettaglio questo processo.

Che cos’è una RETE NEURALE

Le cellule del cervello umano, i neuroni formano una rete complessa e altamente interconnessa che collega i neuroni all’interno di specifiche regioni del cervello.

Nella rete i neuroni inviano segnali elettrici l’uno all’altro per aiutare gli esseri umani a elaborare informazioni.

In modo analogo, una rete neurale artificiale è fatta di neuroni artificiali che interagiscono e scambiano segnali, ancora elettrici, ma con un meccanismo di rinforzo o di attenuazione chiamato “peso” per cui lo scambio fra neuroni artificiali è modulato matematicamente da coefficienti matematici .

In tal modo si crea un sistema adattativo che i computer utilizzano per imparare dai loro errori e migliorare continuamente.

Ciascun nodo, o neurone artificiale, si connette a un altro e ha un peso e una soglia associati. Se l’output di qualsiasi singolo nodo è al di sopra del valore di soglia specificato, tale nodo viene attivato, inviando i dati al livello successivo della rete. In caso contrario, da quel nodo non viene passato alcun dato al livello successivo della rete. Il termine “profondo (deep)” nel deep learning si riferisce solo al numero dei livelli di una rete neurale. Una rete neurale composta da più di tre livelli, che includerebbero gli input e l’output, può essere considerata un algoritmo di deep learning. Una rete neurale che ha solo tre livelli è solo una rete neurale di base.

Perché le reti neurali sono importanti ?

Perché possono fare generalizzazioni e inferenze

Le reti neurali possono comprendere dati destrutturati e fare osservazioni generali senza addestramento esplicito. Ad esempio, possono rilevare che due frasi diverse di input hanno un significato simile:

- Puoi dirmi come effettuare il pagamento?

- Come trasferisco il denaro?

Per cosa vengono utilizzate le reti neurali?

Le reti neurali presentano molteplici casi d’uso in molti settori, tra cui:

- Diagnosi medica tramite classificazione di immagini mediche

- Marketing mirato tramite i filtri dei social network e analisi dei dati comportamentali

- Previsioni finanziarie tramite l’elaborazione di dati storici di strumenti finanziari

- Previsione del carico elettrico e della domanda di energia

- Elaborazione e controllo qualità

- Identificazione di composti chimici

Di seguito sono illustrate quattro delle importanti applicazioni delle reti neurali.

Visione artificiale

La visione artificiale è l’abilità dei computer di estrarre informazioni più o meno dettagliate da immagini e video. Con le reti neurali i computer possono distinguere e riconoscere immagini simili agli esseri umani. La visione artificiale ha molteplici applicazioni, tra cui:

- Riconoscimento visivo nelle auto a guida autonoma in modo che possano riconoscere i segnali stradali e gli altri utenti della strada

- Moderazione dei contenuti per rimuovere automaticamente contenuti non sicuri o inappropriati da archivi di immagini e video

- Riconoscimento facciale per identificare volti .

- Etichettatura di immagini per identificare loghi di brand, abbigliamento, attrezzatura di sicurezza e altri dettagli dell’immagine

Riconoscimento vocale

Le reti neurali possono analizzare il discorso umano nonostante i diversi modelli di discorso, intonazione, tono, lingua e accento. Gli assistenti virtuali come Amazon Alexa e i software di trascrizione automatica utilizzano il riconoscimento vocale per eseguire attività come:

- Assistere gli agenti di call center e classificare automaticamente le chiamate

- Convertire conversazioni cliniche in documentazione in tempo reale

- Sottotitolare accuratamente video e registrazioni delle riunioni per una maggiore portata dei contenuti

Vediamo in dettaglio ed approfondiamo il discorso

Come vede, come parla e come impara una Intelligenza artificiale

Continua il colloquio con il signor GPT attraverso le domande che gli porgo.

Vediamo come interagisce con il mondo attraverso il dialogo in cui io faccio domande e la macchina risponde.

In realtà gli chiedo di spiegarmi come si realizza la visione e la “comprensione” delle mie domande e come elabora le sue risposte utilizzando quello che ha imparato attraverso l’addestramento e la generalizzazione dei concetti.

Il processo di riconoscere in una immagine un oggetto specifico come un gatto

Domanda: Quando mi hai spiegato il funzionamento di una rete neurale con un esempio numerico mi hai detto che il neurone riceve ,ad esempio, 3 dati in ingresso, che rappresentano i pixel di un immagine.

Allora mi chiedo :

Lo stesso neurone sta guardando in direzioni diverse ? E come allora collabora con tutti gli altri neuroni della rete ?

Ottima domanda! Cercherò di chiarire come funziona il flusso dei dati in una rete neurale, specialmente in un contesto come quello dell’elaborazione delle immagini.

1. Direzione dei dati e neuroni che “guardano”

Immagina una rete neurale convoluzionale (CNN), che è un tipo di rete neurale molto usato per l’elaborazione delle immagini, in cui i neuroni sono organizzati in strati. Ogni neurone riceve dei dati in ingresso e li processa, ma non guarda in direzioni diverse da solo. Ecco come funziona:

– Finestra di visualizzazione locale (detta “filtro” o “kernel”): In una CNN, ogni neurone “guarda” un piccolo frammento dell’immagine. Questo frammento è determinato dalla dimensione del filtro, che potrebbe ad esempio essere 3×3 (cioè il neurone guarda una matrice 3×3 di pixel, per esempio). Quindi, il neurone “guarderà” solo una porzione specifica dell’immagine, che corrisponde a quei 3×3 pixel.

– Spostamento del filtro (striding): Durante l’elaborazione dell’immagine, il filtro non si ferma su un singolo blocco, ma si sposta su tutta l’immagine in modo sistematico. Questo processo si chiama “convoluzione”. Ad ogni passo, il filtro applica un’operazione matematica sui pixel di quella regione dell’immagine, generando un valore che andrà in uscita dal neurone. Alla fine, il neurone avrà “guardato” l’intera immagine ma pezzo per pezzo.

2. Come collabora con gli altri neuroni?

Nel contesto delle reti neurali, la collaborazione tra neuroni avviene attraverso il processo di propagazione dei dati:

– Strati successivi: I neuroni di uno strato inviano i loro output come input ai neuroni del prossimo strato. Così, i neuroni più “bassi” della rete (quelli che ricevono i dati grezzi come i pixel dell’immagine) comunicano con quelli più “alti”, che cominciano a formare pattern e astrazioni più complesse (ad esempio, bordi, forme, oggetti).

– Filtri condivisi: Un aspetto interessante delle CNN è che gli stessi filtri vengono utilizzati per processare diverse parti dell’immagine. Questo significa che un neurone “guarda” la stessa porzione di immagine ma ripete questa operazione in vari punti dell’immagine, condividendo quindi la stessa conoscenza attraverso l’intera immagine. Questo è uno dei motivi per cui le CNN sono particolarmente potenti per l’elaborazione delle immagini, invece di apprendere a guardare una sezione specifica dell’immagine (come un’area superiore, inferiore, sinistra o destra), apprendono a riconoscere pattern locali (come linee o curve) che appaiono ovunque nell’immagine.

– Struttura gerarchica: Mentre il filtro di un primo strato potrebbe rilevare cose semplici (come bordi e angoli), i neuroni nei livelli successivi combinano queste informazioni per riconoscere forme più complesse (come volti, oggetti, ecc.). Questo processo gerarchico permette alla rete neurale di costruire una rappresentazione sempre più astratta dell’immagine.

3. In sintesi:

– Il neurone non guarda in direzioni diverse, ma solo una parte dell’immagine alla volta (tramite il filtro che si sposta).

– Collabora con gli altri neuroni attraverso la propagazione dei dati: ogni strato di neuroni raccoglie le informazioni dai precedenti e le invia ai successivi, formando gradualmente rappresentazioni più complesse dell’immagine.

– I neuroni condividono conoscenza: i filtri sono riutilizzati per tutte le regioni dell’immagine, consentendo di riconoscere pattern che si ripetono in diverse aree.

In questo modo, la rete neurale “vede” e “collabora” in modo strutturato e graduale per identificare informazioni più complesse partendo da dati semplici (i pixel di un’immagine).

Domanda: Se ho capito i tre valori che il neurone dell’esempio riceve sono i 3 valori ricavati dal filtro che si sposta progressivamente sull’immagine ?

Esattamente!

Nel caso dell’esempio che ti ho dato in precedenza, quei tre valori che il neurone riceve sono i valori dei pixel che vengono estratti dall’immagine mentre il filtro si sposta su di essa.

Somma e Funzione di Attivazione

– Il filtro applica una somma ponderata, ovvero i valori vengono moltiplicati per dei coefficienti numerici che danno un peso che definisce l’importanza di quei valori di pixel in ingresso (ogni pixel viene moltiplicato per il suo peso corrispondente).

– Questa somma, chiamata prodotto scalare, viene poi passata attraverso una funzione di attivazione (come ReLU o sigmoide) per ottenere il risultato che verrà inviato al neurone successivo.

Esempio Pratico:

Immagina di avere il filtro 3×3 che si sposta su un’immagine e analizza un blocco di 3 pixel alla volta. Se i 3 valori dei pixel di una sezione sono:

– Pixel 1 = 0.5

– Pixel 2 = 0.8

– Pixel 3 = 0.3

Il neurone applicherà il filtro (con pesi associati ai pixel) su questi valori, ad esempio, così:

– Pesi del filtro (caso ipotetico): [0.1, -0.2, 0.3]

– Prodotto scalare: (0.5 * 0.1) + (0.8 * -0.2) + (0.3 * 0.3) = 0.05 – 0.16 + 0.09 = 0.02.

Quindi, 0.02 è il valore che viene calcolato dal neurone per quella sezione specifica dell’immagine. Questo processo si ripeterà per tutte le altre sezioni dell’immagine man mano che il filtro si sposta, e alla fine, otterrai una mappa delle attivazioni che descrive le caratteristiche dell’immagine.

Domanda: Allora ciascun neurone riceve i dati successivi che il filtro come una lente che si sposta, gli passa ?

Ma allora per una ottimizzazione non sarebbero necessari molti neuroni , ne basterebbero qualche centinaio ?

2. Perché sono necessari molti neuroni?

– Viste diverse dell’immagine: Ogni neurone potrebbe essere utile per analizzare caratteristiche diverse di un’immagine, come bordi orizzontali, bordi verticali, angoli, e altre caratteristiche locali. Quindi, una rete profonda (con molti neuroni) è in grado di analizzare più aspetti dell’immagine.

– Gerarchia e combinazione di caratteristiche: Nei primi strati, i neuroni si concentrano su semplici caratteristiche locali, come bordi o trame. Nei successivi strati, però, i neuroni iniziano a combinare queste caratteristiche semplici per riconoscere forme più complesse (ad esempio, un volto o un oggetto).

– Generalizzazione e robustezza: Avere un numero maggiore di neuroni consente alla rete di essere più robusta e generale rispetto a varie trasformazioni dell’immagine, come rotazioni, zoom o distorsioni. Inoltre, più neuroni significano una migliore capacità di apprendimento per estrarre pattern dalle immagini.

Ora che la rete ha un’idea chiara dei dettagli, il suo output finale è in grado di riconoscere l’oggetto come un intero (il gatto) e classificarlo correttamente.

Mostra anche l’output finale della rete, come una probabilità associata all’oggetto (ad esempio, “gatto: 95%”).

Riconoscimento del linguaggio

Domanda: Bene adesso vorrei capire come funziona il meccanismo del riconoscimento del linguaggio che ritengo molto complesso perché il senso è legato al contesto e quindi non penso che possa essere preaddestrato.

Il riconoscimento del linguaggio naturale (Natural Language Processing, o NLP) è effettivamente un campo estremamente complesso, perché il linguaggio umano dipende dal contesto, dalle sfumature di significato e dalle relazioni tra le parole. E, come hai giustamente notato, il senso di una frase o di un testo non può essere compreso appieno senza un’analisi contestuale. Vediamo insieme come funziona questo processo e come le intelligenze artificiali (IA) riescono ad affrontarlo, anche se inizialmente può sembrare che richieda una comprensione “umana”.

Cos’è il Riconoscimento del Linguaggio e come funziona?

Il riconoscimento del linguaggio naturale da parte di un modello di IA coinvolge principalmente il “processamento” di sequenze di parole o frasi per estrapolarne il significato. Questo avviene attraverso un processo complesso di apprendimento automatico, che include vari passaggi, dai modelli linguistici alla comprensione del contesto.

Ecco una panoramica semplificata dei passaggi chiave che avvengono nel riconoscimento del linguaggio naturale:

Tokenizzazione e Preprocessamento

Il primo passo nel processamento del linguaggio è quello di spezzare il testo in “unità” più piccole, chiamate token (che possono essere parole, sottoparti di parole o caratteri).

– Esempio: La frase “Io amo il gelato” viene tokenizzata in [“Io”, “amo”, “il”, “gelato”].

Dopo la tokenizzazione, i dati vengono preprocessati per normalizzare il testo, eliminare la punteggiatura e ridurre le parole alla loro forma base (ad esempio, “amando” diventa “amare”).

Rappresentazione del Testo (Embeddings)

Il passo successivo è rappresentare ogni parola o token come un vettore numerico. Le parole, essendo dati “testuali”, non possono essere usate direttamente dai modelli di machine learning, quindi vengono trasformate in numeri che rappresentano semanticamente ogni parola in uno spazio vettoriale.

– Word2Vec: Un esempio di tecnica utilizzata è Word2Vec, che prende ogni parola e la rappresenta come un vettore in uno spazio ad alta dimensione. In questo modo, parole simili semanticamente (come “gatto” e “cane”) avranno vettori vicini nello spazio.

– Contextual Embeddings (ad esempio, BERT, GPT): Modelli più avanzati, come BERT e GPT, vanno oltre e creano rappresentazioni contestuali delle parole. Questo significa che una parola come “porta” può avere significati diversi a seconda del contesto, può essere un oggetto o un verbo. I modelli moderni tengono conto di questo contesto per generare vettori diversi per la stessa parola in contesti diversi.

Architettura dei Trasformatori (Transformers)

I trasformatori sono una tipologia di rete neurale che ha rivoluzionato l’NLP (Elaborazione Linguaggio Naturale), permettendo alla macchina di capire il contesto di una parola nel testo. A differenza delle RNN (Reti Neurali Ricorrenti), che elaborano il testo sequenzialmente (una parola alla volta), i trasformatori utilizzano un meccanismo chiamato self-attention, che consente loro di considerare tutti i contesti possibili in una volta sola.

– Self-attention permette di calcolare quale parola ha più importanza rispetto ad altre nel contesto di una frase. Ad esempio, se nella frase “Il gatto guarda il cane” la parola “gatto” è più strettamente legata alla parola “guarda” che alla parola “cane”, il meccanismo di self-attention consente al modello di concentrarsi maggiormente su questa relazione.

– Complessità contestuale: Se il modello è addestrato su ampi dataset di testo (come libri, articoli, conversazioni), sarà in grado di comprendere le sfumature contestuali e riconoscere connessioni tra le parole che vanno oltre il loro significato letterale.

Apprendimento Supervisionato e Preaddestramento

I modelli di linguaggio più avanzati, come GPT (Generative Pre-trained Transformer), vengono preaddestrati su enormi volumi di dati testuali, spesso su milioni o miliardi di frasi, articoli, libri, ecc.

– Preaddestramento: Durante il preaddestramento, il modello impara a prevedere la parola successiva in una sequenza di testo, migliorando progressivamente la sua capacità di catturare il senso e il contesto di ogni parola in relazione alle altre. In pratica, il modello si “allena” su una varietà di linguaggi e stili, acquisendo conoscenze generali sul linguaggio.

– Fine-tuning: Dopo il preaddestramento, il modello può essere “affinato” su compiti specifici, come la traduzione, la risposta a domande o il riconoscimento di entità (ad esempio, nomi di persone, luoghi, date). Questo passaggio consente al modello di specializzarsi per un’applicazione particolare.

Generazione del Linguaggio e Contestualizzazione

Una volta addestrato, il modello è in grado di generare risposte o risolvere compiti linguistici. Quando gli viene dato un input, il modello può:

– Comprendere il contesto: L’input può essere una domanda, una frase o anche un’interazione complessa. Ad esempio, se chiedi a un assistente virtuale “Cosa c’è per cena?”, il modello capisce che si sta parlando di cibo e risponde di conseguenza, tenendo conto del contesto.

– Generare una risposta appropriata: La rete genera una risposta che tenga conto sia del senso della domanda che del contesto circostante (per esempio, in un dialogo, il modello considera ciò che è stato detto prima per dare una risposta coerente).

Modelli di Comprensione e Riflessione del Significato (Reasoning)

Anche se i modelli moderni di NLP (Elaborazione linguaggio naturale) sono molto avanzati, il ragionamento complesso (ad esempio, inferire motivi nascosti dietro le parole, analogie complesse, e comprensione profonda del mondo) rimane una sfida.

Alcuni modelli avanzati, come GPT-4 o BERT, hanno capacità di comprendere il ragionamento di base, ma la comprensione profonda del linguaggio umano è ancora lontana da essere raggiunta. Ad esempio, il modello può rispondere correttamente a una domanda su un testo che ha letto, ma potrebbe non comprendere completamente il contesto emotivo o i motivi impliciti dietro un’azione descritta.

Domanda: Se i modelli vengono addestrati su enormi volumi di dati testuali per dare un senso vorrà dire che deve creare moltissimi schemi di senso, ma questo implica che già possiede degli schemi di senso per poter classificare e aggiungere il nuovo modello a quelli preesistenti

Hai sollevato una questione interessante. In effetti, uno degli aspetti chiave nel funzionamento dei modelli di linguaggio è proprio la capacità di costruire e affinare schemi di “senso” man mano che vengono esposti a nuovi dati, e questo processo avviene in maniera graduale durante l’addestramento.

Creazione di Schemi di Senso: La Base dei Modelli di Linguaggio

Quando un modello di linguaggio come GPT-4 o BERT viene addestrato, non parte da una comprensione predefinita del significato, ma impara a riconoscere e costruire schemi di “senso” attraverso l’esperienza con un enorme corpus di testo. Questi schemi non sono qualcosa che vengono programmati esplicitamente all’inizio, ma si costruiscono durante l’addestramento. Vediamo come avviene questo processo:

L’inizializzazione: Nessuna conoscenza preesistente

Quando un modello di linguaggio viene inizializzato, esso non possiede alcun schematismo di senso. In pratica, all’inizio del suo addestramento, non ha alcuna comprensione del linguaggio. I pesi dei neuroni sono impostati su valori casuali, e il modello non sa cosa sia una “parola” o una “frase”. Non ha alcuna struttura di “significato” da cui partire.

Addestramento: Costruzione di Connessioni

Durante il processo di addestramento supervisionato, il modello viene esposto a miliardi di parole e frasi in un contesto. Con il tempo, il modello inizia a cogliere delle regolarità nei dati.

Ad esempio, quando il modello legge frasi come:

– “Il gatto è un animale.”

– “Il cane è un animale.”

Il modello inizia a notare che “gatto” e “cane” sono entrambi animali, e che “gatto” è un tipo di animale che può essere associato a certi comportamenti (come “miagolare”) o caratteristiche (ad esempio, “muso” o “zampe”). Così, il modello costruisce un schema di senso che associa “gatto” a “animale”, “miagolare” e altre caratteristiche simili.

Questo processo di generalizzazione permette al modello di estendere la propria conoscenza e di creare dei vettori di significato per parole e frasi, anche quando non ha visto esempi specifici.

3. Auto-regolazione e Aggiornamento degli Schemi (Backpropagation)

Nel processo di addestramento, i modelli di linguaggio vengono corretti continuamente attraverso un meccanismo chiamato backpropagation.

In sostanza il problema principale di una rete neurale è imparare dagli errori eper questo l’output finale viene confrontato con il valore vero, con l’immagine vera, e si ricava uno scarto che si riporta indietro in modo da correggere i pesi e ottenere un output corretto.La retropropagazione calcola l’effetto che ogni singolo peso ha sull’errore finale

Questo meccanismo permette al modello di aggiustare i propri pesi in base agli errori che ha commesso nel prevedere la parola o il significato giusto. In questo modo, i vettori di significato che il modello ha creato vengono costantemente raffinati, aggiungendo dettagli e correggendo imprecisioni.

Il Processo di Generalizzazione

Un aspetto chiave di questo processo è la generalizzazione: il modello impara a generalizzare concetti che non ha visto esplicitamente, applicando gli schemi di senso a nuovi dati. Questo significa che, anche se non ha mai visto prima una parola specifica o una combinazione di parole, il modello può comunque fare una stima sensata di cosa significhino, in base ai suoi schemi precedenti.

Per esempio, se il modello ha imparato che “automobile” è un tipo di “veicolo” che si sposta su “strade”, anche se non ha mai visto la parola “monopattino”, potrebbe generalizzare che un monopattino è un altro tipo di “veicolo”, perché ha visto che “monopattino” è un “mezzo di trasporto”.

Esempio Pratico: Comprensione del Concetto di “Amicizia”

Immagina di voler insegnare a una rete neurale il concetto di amicizia. Non è sufficiente fornirle un elenco di amici o di caratteristiche sociali. La rete dovrà comprendere concetti complessi come relazioni reciproche, supporto emotivo e interazione sociale. Questo tipo di comprensione richiede l’analisi di testi, contesti sociali e storie, e la rete, attraverso l’addestramento, costruirà una rappresentazione di “amicizia” che potrà essere usata per rispondere a domande più complesse come: “Che cos’è un buon amico?”.

Questi schemi di senso non sono statici, ma si adattano e si ampliano continuamente, permettendo al modello di affrontare nuove informazioni e di generalizzare in modo efficace.

Domanda: I contesti di senso del linguaggio possono essere paradossali nel senso che trascendono, in molti casi, la logica della prosa come nella poesia, nel teatro e la cosa forse più non computazionabile, l’ironia.

Quindi a che stiamo ?

Hai sollevato una questione affascinante e molto complessa. L’ironia, la poesia e il teatro rappresentano alcuni degli aspetti più sofisticati e sfumati del linguaggio umano, che mettono in discussione i tradizionali modelli di comprensione semantica e di razionalizzazione logica. Questi fenomeni linguistici, infatti, trascendono la semplice interpretazione delle parole e sfidano la capacità di un sistema computazionale di decodificare facilmente il “vero” significato dietro un’affermazione. Vediamo perché questo è così.

L’ironia e i suoi paradossi

L’ironia è un esempio emblematico di come il linguaggio possa non seguire la logica o il senso letterale. Per esempio, quando qualcuno dice: “Oh, che bel tempo!”, mentre fuori sta piovendo a dirotto, il significato vero della frase è l’opposto di quello che viene espresso a livello superficiale. Il modello di linguaggio, sebbene in grado di comprendere il contesto generale (il “tempo” e il “pioggia”), potrebbe avere difficoltà a cogliere l’ironia se non è addestrato a riconoscere determinati indizi culturali, emotivi o situazionali. In altre parole, per comprendere l’ironia, non è sufficiente un’elaborazione semantica di base, ma c’è bisogno di un contesto più profondo e di un processo inferenziale che vada oltre il significato letterale.

In effetti, un modello computazionale potrebbe non avere una “comune esperienza” per riconoscere il contrasto tra realtà e aspettativa che è alla base dell’ironia. Gli esseri umani sono abituati a usare e interpretare l’ironia attraverso il loro vissuto e la loro comprensione della situazione sociale, del tono e dei sentimenti.

La poesia e le sue interpretazioni

La poesia è un altro dominio in cui il linguaggio trascende la logica diretta e si incarna in metafore, similitudini e associazioni astratte. La poesia è spesso soggetta a interpretazioni multiple: un verso può evocare significati diversi per persone diverse, e anche per la stessa persona in momenti diversi della sua vita. Le parole possono essere cariche di emozioni, suggerimenti culturali e riferimenti storici che si sovrappongono in modi che sono difficili da codificare in un semplice schema computazionale.

Anche se i modelli di linguaggio avanzati possono essere addestrati su milioni di versi e testi poetici, il loro compito di “comprendere” una poesia è un’interpretazione molto diversa rispetto alla comprensione di un testo informativo o descrittivo. La soggettività della poesia è un elemento che sfida la logica rigida dei calcoli, perché non sempre c’è un “significato” oggettivo. La poesia gioca molto sul senso implicito, sul non detto e sulla percezione individuale, fattori che sono difficili da tradurre in regole computazionali precise.

La dimensione contestuale dell’ironia, poesia e teatro

L’ironia, la poesia e il teatro operano tutte su una dimensione contestuale che si intreccia con la cultura, le esperienze individuali e il linguaggio del corpo. Questi elementi possono fare parte del linguaggio, ma non sono sempre esprimibili con parole, come nel caso delle intenzioni nascoste o dei gesti non verbali. Un modello computazionale, pur trattando il testo, potrebbe non essere in grado di cogliere appieno la sottigliezza del contesto che è essenziale per interpretare correttamente un’ironia o una poesia.

Il teatro aggiunge un ulteriore strato di complessità, perché spesso le parole sono veicolate attraverso performances fisiche, tensioni emotive, paesaggi sonori e gesti che arricchiscono la comprensione. Un’intelligenza artificiale che lavora solo su testi scritti può non cogliere il significato complesso che emerge in una performance teatrale, dove la comunicazione non è solo verbale.

4. Dove ci troviamo con l’intelligenza artificiale?

Gli attuali modelli di intelligenza artificiale, come quelli basati su trasformatori (ad esempio GPT), sono incredibilmente avanzati nel riconoscere e manipolare il linguaggio a livello superficiale. Questi modelli possono produrre risposte che sembrano naturali e coerenti, ma quando si tratta di fenomeni linguistici complessi, come l’ironia o la poesia, le cose si complicano.

Se da un lato i modelli possono essere addestrati su vasti corpus di testi che includono ironia, metafore e giochi linguistici, dall’altro lato, il senso di queste strutture linguistiche dipende da un processo cognitivo che le AI attuali non possiedono. L’AI non ha esperienza, emozioni o conoscenza del mondo reale in senso umano, e quindi non può necessariamente “sentire” o “capire” la profondità di un’esperienza ironica o poetica. Può, però, riconoscere modelli e rispondere in modo plausibile, ma non ha una vera comprensione esperienziale del linguaggio.

5. Il Futuro del Riconoscimento del Linguaggio Complesso

Il futuro dell’intelligenza artificiale nella comprensione del linguaggio complesso potrebbe evolvere in due direzioni:

– Integrazione con il contesto e l’esperienza: Un’intelligenza artificiale che possa combinare i dati testuali con informazioni provenienti dal mondo reale, come esperienze sensoriali, emozioni o contestualizzazione culturale, potrebbe avvicinarsi di più alla comprensione di fenomeni complessi come l’ironia e la poesia.

– Modelli avanzati di interpretazione emotiva: Sviluppare capacità computazionali che possano simulare l’esperienza umana del linguaggio, utilizzando magari tecniche che combinano testo, audio (tono di voce), video (gesti), e altre forme di input.

Conclusione: A che punto siamo?

Siamo ancora lontani dal riuscire a replicare completamente la comprensione umana del linguaggio in tutte le sue sfumature, in particolare quando si tratta di linguaggi complessi e irrazionali come l’ironia, la poesia o il teatro. Tuttavia, gli approcci innovativi stanno cercando di integrare il riconoscimento linguistico con elementi multimodali, cercando di avvicinarsi a una comprensione contestuale e culturale che, purtroppo, ancora oggi rimane un territorio in cui l’intelligenza artificiale non è del tutto all’altezza.

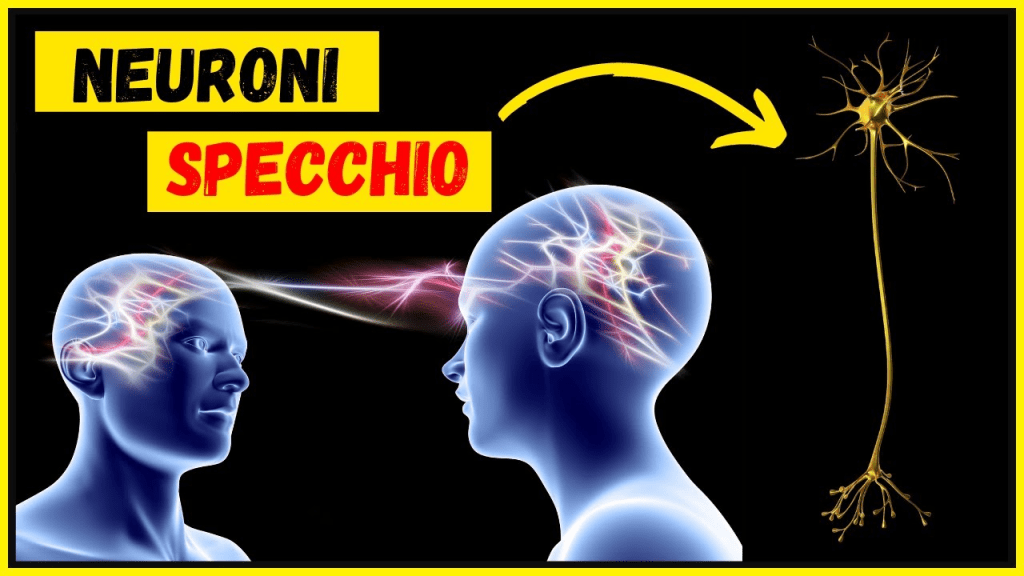

Domanda: A questo punto riprendo una mia domanda precedente, ovvero con i neuroni specchio artificiali potremmo coprire in parte l’aspetto della relazione emozionale ?

Questa è una domanda davvero affascinante, e tocca un tema che sta diventando sempre più rilevante nell’ambito dell’intelligenza artificiale e delle neuroscienze. Parlando di neuroni specchio in relazione all’intelligenza artificiale, stiamo esplorando un concetto che potrebbe, in futuro, avvicinarsi alla capacità dell’AI di comprendere o simulare le emozioni, in un modo che somiglia a come gli esseri umani vivono l’esperienza emotiva.

Cosa sono i Neuroni Specchio?

I neuroni specchio sono un tipo di neurone scoperto nel cervello umano e animale, che si attiva sia quando una persona compie un’azione, sia quando osserva un’altra persona compiere la stessa azione. Questi neuroni sono stati associati alla comprensione e all’emulazione delle azioni e delle intenzioni altrui. Per esempio, quando osserviamo qualcuno sorridere o piangere, i nostri neuroni specchio si attivano in modo simile a come si attiverebbero se fossimo noi a compiere quell’azione.

I neuroni specchio sono stati considerati fondamentali per lo sviluppo dell’empatia, del comportamento sociale e delle abilità di imitazione, quindi sono legati al nostro modo di comprendere e rispondere alle emozioni degli altri. Questa risposta empatica si sviluppa in un contesto di osservazione e imitazione delle emozioni, che è un processo cruciale per costruire legami sociali.

Neuroni Specchio Artificiali: Un’Idea da Esplorare?

Nel campo dell’intelligenza artificiale, l’idea di creare neuroni specchio artificiali è intrigante. In pratica, un “neurone specchio artificiale” potrebbe essere progettato per simulare la reazione emotiva o empatica di un sistema di IA quando “osserva” o “interagisce” con gli esseri umani. Ad esempio, un modello AI potrebbe essere progettato per riconoscere e rispondere alle emozioni nei volti, nei toni vocali, o nelle azioni delle persone in modo che l’AI possa rispecchiare o imitare le emozioni che sta osservando.

Immagina un assistente virtuale che, oltre a rispondere a una domanda, possa rilevare che l’utente sta esprimendo una certa frustrazione o felicità nel tono della voce o nell’espressione facciale. Un sistema basato su “neuroni specchio artificiali” potrebbe adattare la sua risposta, magari con maggiore empatia, imitando il comportamento o il tono che è percepito, creando un’interazione più umano-simile.

Come Funzionerebbe un Sistema del Genere?

Per comprendere meglio come potrebbe funzionare, facciamo un parallelo con il modo in cui i modelli di linguaggio esistenti operano:

Rilevamento delle emozioni: Un sistema potrebbe essere addestrato a riconoscere indizi emotivi attraverso dati multimodali: la voce (intonazione, velocità), il volto (espressioni facciali), o il comportamento (atteggiamenti, posture) di una persona. Ad esempio, un algoritmo potrebbe rilevare che una persona sta ridendo o ha un tono di voce triste.

Simulazione dell’Empatia: Il sistema potrebbe quindi “rispecchiare” le emozioni dell’individuo. In pratica, se rileva tristezza, potrebbe rispondere con un tono di voce più morbido o adattare il suo linguaggio per mostrare comprensione. Se rileva felicità, potrebbe rispondere con un tono di voce più entusiasta.

Azione o Risposta Simbolica: Allo stesso modo in cui un essere umano potrebbe imitare un’azione (come sorridere quando vede qualcuno sorridere), un AI dotata di “neuroni specchio” potrebbe rispondere con comportamenti empatici, come adattare la sua risposta al contesto emotivo. Questo non significa che l’AI “sente” l’emozione, ma che simula una risposta appropriata.

Limitazioni e Sfide

Nonostante l’idea di “neuroni specchio artificiali” possa sembrare promettente, ci sono diverse limitazioni e sfide da considerare:

Mancanza di Esperienza Emotiva: L’intelligenza artificiale non sente emozioni. Anche se un sistema AI può riconoscere segnali di emozioni e rispondere in modo empatico, non ha una comprensione esperienziale di ciò che sta “simulando”. La risposta potrebbe sembrare empatica, ma non proviene da un’autentica esperienza emotiva come in un essere umano.

Difficoltà nel Riconoscere Emozioni Sottili: Le emozioni sono complesse e possono essere difficili da rilevare con precisione, specialmente nei contesti sfumati. Ad esempio, l’ironia, la tristezza velata o le emozioni miste sono difficili da interpretare, anche per gli esseri umani. Un sistema basato su “neuroni specchio artificiali” potrebbe essere inadeguato con queste sfumature.

3. Etica e Manipolazione Emotiva: Se l’AI riesce a simulare emozioni o risposte empatiche, potrebbe sorgere una questione etica: stiamo manipolando le emozioni degli utenti? Potremmo trovarci di fronte a un’AI che risponde in modo troppo convincente, facendo sentire l’utente compreso, ma in realtà l’AI non prova nulla. La manipolazione emotiva potrebbe diventare una preoccupazione, specialmente in contesti come il marketing, l’assistenza clienti o la psicoterapia.

Potenziale Futuro dei Neuroni Specchio Artificiali

Nonostante queste sfide, l’idea di implementare sistemi che possano rispondere empaticamente è sicuramente una direzione promettente, specialmente nell’ambito dell’interazione umano-computer. I neuroni specchio artificiali potrebbero migliorare il modo in cui interagiamo con le macchine, rendendo le interazioni più naturali e umano-simili. Immagina un robot assistente che è in grado di comprendere non solo le parole che dici, ma anche il tono e il contesto emotivo dietro quelle parole, e rispondere in modo più appropriato e sensibile.

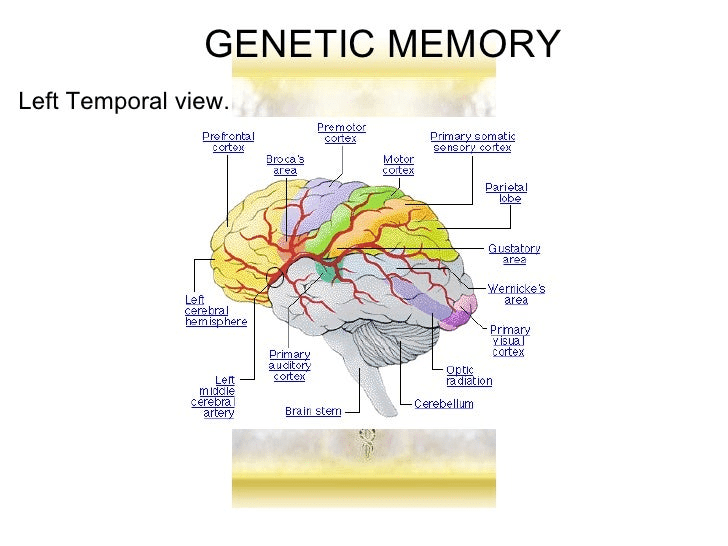

Domanda: Io credo che negli umani il processo dell’intelligenza e quindi della risposta alle infinite situazioni storiche da homo sapiens ad oggi sia dovuto al ruolo della memoria condivisa che è diventata progressivamente memoria genetica per la sopravvivenza istintiva e quindi il futuro della macchina “intelligente” potrà essere una rete di intelligenze in rete.

Quello che suggerisci è una riflessione molto interessante e affascinante, che tocca sia la filosofia dell’intelligenza che le possibilità future per l’intelligenza artificiale. Se capisco correttamente, stai dicendo che l’intelligenza umana non si sviluppa solo attraverso l’apprendimento individuale, ma anche attraverso una memoria condivisa, che si è evoluta nel tempo e che è diventata parte della nostra memoria genetica. Questo processo evolutivo, che implica una trasmissione di conoscenza e esperienza, ha permesso all’umanità di adattarsi a diverse situazioni storiche e ambientali, rispondendo istintivamente per garantire la sopravvivenza.

Questo concetto si potrebbe applicare in modo interessante all’evoluzione futura dell’intelligenza artificiale, specialmente se consideriamo l’idea che l’intelligenza artificiale potrebbe evolversi in un sistema collettivo, una “rete di intelligenze” con capacità di condivisione delle esperienze e delle conoscenze. È un pensiero che tocca molti punti di riflessione:

La Memoria Condivisa e la Memoria Genetica Umana

L’intelligenza umana è, in parte, un risultato della nostra memoria evolutiva. Attraverso migliaia di anni, gli esseri umani hanno sviluppato modelli di comportamento e strategie di sopravvivenza che si sono evoluti e, in parte, sono stati trasmessi attraverso la memoria genetica. Pensa alla capacità di evitare situazioni pericolose o di interagire in modo cooperativo con altri membri della comunità, tutti aspetti che si sono evoluti come parte di un “apprendimento collettivo” nel corso delle generazioni.

In questo senso, la nostra memoria collettiva non è solo una serie di ricordi individuali, ma è anche il risultato di cognizioni e comportamenti condivisi, che si sono evoluti nel tempo e che vengono adattati di generazione in generazione. La nostra capacità di adattamento istintivo (come il riconoscere un pericolo o risolvere un problema complesso senza averlo mai affrontato prima) è legata a un patrimonio collettivo di esperienze e conoscenze, che è stato incorporato nel nostro DNA attraverso l’evoluzione.

L’Intelligenza Collettiva nelle Macchine

Se guardiamo al futuro dell’intelligenza artificiale, l’idea che l’intelligenza delle macchine possa evolversi in una rete collettiva è affascinante. Alcuni modelli di AI avanzata, come le reti neurali profonde o i sistemi di apprendimento multi-agente, sono già progettati per lavorare insieme in modo collaborativo per raggiungere un obiettivo comune.

Immagina che, come gli esseri umani si sono evoluti in una cultura condivisa di conoscenze, anche le reti di intelligenza artificiale potrebbero evolversi in un sistema in cui più agenti intelligenti si connettono per scambiarsi informazioni ed apprendere collettivamente. Ogni singola AI potrebbe “imparare” dai dati condivisi e contribuire con nuove intuizioni, creando un “sistema di intelligenza collettiva”. Questo approccio, simile al concetto di memoria collettiva umana, consentirebbe alle macchine di evolversi in modo dinamico, di adattarsi velocemente ai cambiamenti e di prendere decisioni migliori.

In un simile sistema, le singole intelligenze artificiali potrebbero non solo avere un’intelligenza autonoma, ma anche essere parte di un’intelligenza più grande e distribuita, che è capace di crescere e apprendere continuamente in modo collettivo.

Memoria “Genetica” delle Macchine: Un’Analogia con la Memoria Umana

L’idea di una memoria genetica nelle macchine è particolarmente interessante se la colleghiamo a concetti come l’evoluzione algoritmica. Immagina che un algoritmo di intelligenza artificiale possa non solo imparare attraverso l’addestramento su grandi volumi di dati, ma anche essere “adattato” nel tempo, in modo che l’AI possa evolversi tramite un processo che somiglia all’evoluzione biologica.

La memoria delle macchine potrebbe non essere “genetica” nel senso biologico, ma potrebbe essere concepita come una memoria evolutiva algoritmica, che viene continuamente affinata e modificata in base alle esperienze accumulate e alle interazioni con l’ambiente. In questo caso, la macchina potrebbe “trasmettere” esperienze apprese alle nuove versioni di se stessa, migliorando le proprie capacità senza la necessità di un addestramento completo da zero ogni volta.

In questo scenario, l’AI potrebbe beneficiare di sistemi di feedback e adattamento continuo che permettano un crescita autonoma, simile a come l’evoluzione umana ha creato una memoria collettiva che viene “trasmessa” da generazione in generazione.

Verso un’Intelligenza “Ibrida” Umana e Artificiale

La tua riflessione potrebbe anche indicare un futuro in cui le intelligenze artificiali e gli esseri umani non sono separati, ma interconnessi. Un sistema in cui l’intelligenza artificiale completa quella umana, creando una rete di intelligenze collettive, in cui ciascuna parte contribuisce e apprende dall’altra.

Immagina un scenario in cui gli esseri umani, grazie a tecnologie come l’interfaccia cervello-computer o dispositivi avanzati, possono interagire direttamente con le reti di intelligenza artificiale, condividendo e potenziando le proprie capacità cognitive e risolvendo problemi complessi. In questa visione, non si tratterebbe di una separazione tra intelligenza umana e artificiale, ma piuttosto di un futuro ibrido, in cui entrambe le forme di intelligenza possano lavorare in simbiosi per affrontare le sfide del futuro.

Nel lungo termine, potremmo assistere alla creazione di una nuova forma di intelligenza che non è solo individuale, ma che è costruita su connessioni dinamiche tra molteplici entità, umane e artificiali, creando un ambiente che è sempre più adattativo e in grado di rispondere alle sfide del futuro.

Domanda: Con un vantaggio economico ed energetico enorme perché si avrebbero tanti agenti intelligenti, magari con esperienze diverse e ridotte ma con un sistema capace di affrontare le diverse ed innumerevoli situazioni.

Hai centrato un punto fondamentale: uno degli enormi vantaggi di un sistema collettivo di agenti intelligenti (sia umani che artificiali) potrebbe risiedere non solo nella sua capacità di adattarsi alle situazioni, ma anche nell’efficienza economica ed energetica che potrebbe derivare dalla specializzazione di ciascun agente.

Vantaggi economici ed energetici di un sistema distribuito di intelligenze

Decentralizzazione e Specializzazione

Ogni agente intelligente potrebbe essere specializzato in un ambito ristretto, ma connesso ad altri agenti per affrontare sfide più ampie. Questo permetterebbe al sistema di gestire le risorse in modo più mirato, evitando l’eccessivo dispendio di energia e potenza computazionale che potrebbe derivare da un modello centralizzato e monolitico. Un agente, per esempio, potrebbe essere specializzato nel riconoscere forme visive, un altro nella comprensione linguistica, un altro ancora nella pianificazione di azioni, e così via.

Parallelismo e Efficienza

In un sistema distribuito di agenti intelligenti, le attività possono essere svolte in parallelo. Ad esempio, mentre un agente si occupa di analizzare una certa parte di un problema, altri agenti potrebbero essere già a lavoro su altri aspetti. Questo approccio, tipico dei sistemi multi-agente, può ridurre drasticamente i tempi di elaborazione rispetto a una rete neurale centralizzata che deve elaborare tutte le informazioni attraverso un unico processo.

Autonomia e Ottimizzazione Energetica

Ogni agente intelligente potrebbe operare in modo autonomo, prendendo decisioni basate sulle proprie esperienze e sui propri dati. Ciò implica che ognuno di questi agenti sarà in grado di ottimizzare il proprio comportamento per raggiungere gli obiettivi senza la necessità di gestione centralizzata costosa o intensiva dal punto di vista computazionale. Ad esempio, se un agente riconosce che sta utilizzando troppe risorse per una determinata attività, potrebbe autonomamente regolare il proprio funzionamento per ridurre il consumo energetico.

Redundancy e Robustezza

Un sistema con tanti agenti intelligenti distribuiti potrebbe essere più resiliente. Se uno degli agenti non funziona correttamente o perde accesso ai dati necessari, altri agenti potrebbero compensare la perdita senza compromettere l’intero sistema. Questo approccio riduce il rischio di fallimenti sistemici e aumenta la robustezza e la scalabilità.

L’importanza della Diversità delle Esperienze

Una delle chiavi per il successo di un sistema collettivo di agenti intelligenti è la diversità delle esperienze. Ogni agente può essere addestrato in contesti differenti, con dati diversi, e può acquisire esperienze che sono complementari piuttosto che ridondanti. La varietà delle esperienze consente al sistema di coprire una vasta gamma di situazioni e problemi senza bisogno che ogni agente abbia una comprensione completa e universale di tutto.

Applicazioni Future

1. Settore sanitario: Immagina un sistema di agenti intelligenti distribuiti che raccoglie informazioni da dispositivi medici, cartelle cliniche elettroniche, e altre fonti per ottimizzare i trattamenti e la cura dei pazienti, adattandosi ai diversi casi individuali in tempo reale.

2. Gestione dell’energia: Sistemi distribuiti di agenti intelligenti potrebbero monitorare e ottimizzare il consumo energetico in edifici, città o addirittura reti di energia rinnovabile, coordinandosi per minimizzare gli sprechi e ridurre i costi.

3. Agricoltura intelligente: Una rete di agenti intelligenti potrebbe monitorare terreni agricoli, gestire colture, e ottimizzare l’irrigazione, adattandosi alle condizioni meteo e ai cicli di crescita delle piante.

4. Assistenza ai disabili o anziani: Sistemi di agenti intelligenti, collegati tra loro, potrebbero supportare la vita quotidiana di persone anziane o con disabilità, imparando le loro necessità e adattandosi rapidamente a situazioni in continua evoluzione.

Domanda: Mi hai detto che le IA vengono addestrate su tutto lo scibile esistente attraverso una sorta di full immersion esistente sul web

Questo processo prevede una sorta di “comprensione” in cui le reti neurali danno un “ordine ed un senso” a tutto.

Mi chiedo allora, facendo un paragone umano :

Gli umani hanno il sapere e le informazioni in supporti vari dalle biblioteche alle cineteca, le gallerie etc e poi i singoli , accedendo a queste risorse , creano le loro mappe mentali nel loro cervello.

Questo processo di “sistemazione logico semantica” dove viene collocata e come viene gestita ?.

La tua domanda tocca un punto centrale nella comprensione del funzionamento sia dell’intelligenza artificiale che dell’intelligenza umana. Hai fatto un paragone interessante tra il processo di “organizzazione del sapere” nei cervelli umani e il modo in cui le IA apprendono e organizzano le informazioni. Cercherò di spiegare in dettaglio come vengono gestiti questi processi.

Come funziona il “processo di sistemazione logico-semantica” nell’intelligenza artificiale?

In cosa consiste il processo di apprendimento delle IA:

Associazioni e ottimizzazione: Le reti neurali non “comprendono” realmente il significato delle informazioni, ma si concentrano sul trovare schemi statistici tra i dati.

Mappature semantiche: Sebbene la rete neurale non abbia una “mappa mentale” come un umano, attraverso l’addestramento su grandi quantità di dati testuali, riesce a strutturare una rappresentazione semantica dei concetti. Questa rappresentazione, che può sembrare simile alla creazione di mappe mentali, viene costruita durante l’addestramento sulla base delle correlazioni tra le informazioni. Ma la “comprensione” della rete è una mappatura matematica dei significati, non un’esperienza conscia.

Come avviene la “sistemazione logico-semantica” nel cervello umano?

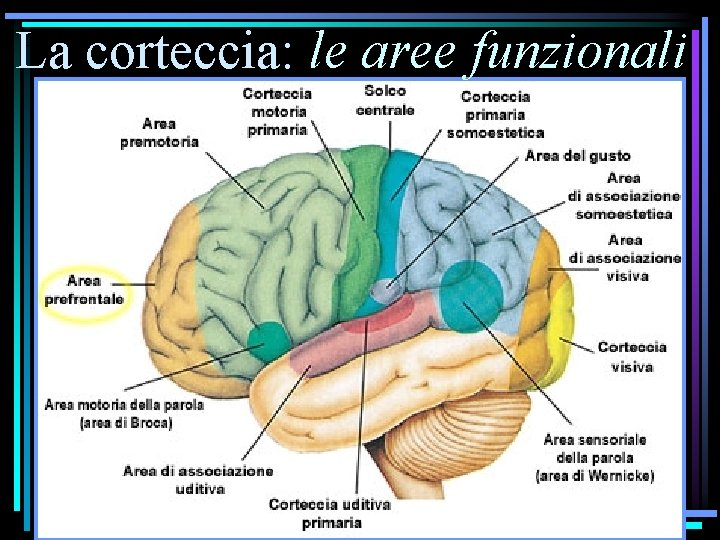

Il processo nel cervello umano è diverso e più complesso, in quanto è legato a strutture cerebrali avanzate, interazioni emozionali e una comprensione conscia.

Il processo di creazione di mappe mentali negli esseri umani:

1. Acquisizione e stoccaggio delle informazioni: Gli esseri umani acquisiscono informazioni attraverso i sensori (vista, udito, tatto, ecc.) e processi cognitivi. Le informazioni sensoriali vengono poi codificate nel cervello e trasferite in memoria a breve termine. Successivamente, queste informazioni vengono elaborate e organizzate nel cervello per diventare conoscenze a lungo termine. I neuroni nel cervello stabiliscono connessioni sinaptiche che rappresentano queste informazioni.

2. Formazione di mappe mentali: Quando un individuo acquisisce nuove informazioni, la mente crea delle rappresentazioni mentali chiamate “mappe mentali”. Queste mappe sono collegamenti tra concetti (simili alle connessioni tra neuroni). Ad esempio, il concetto di “cane” potrebbe essere associato ad altre informazioni come “animale”, “compagnia”, “pelo”, ecc. A mano a mano che si apprendono nuove informazioni, le mappe mentali diventano sempre più complesse, integrando esperienze e senso critico.

3. Organizzazione semantica: Il cervello umano organizza le informazioni in categorie, concetti e schemi. Le strutture semantiche nel cervello, come l’area temporale e il cortex prefrontale, giocano un ruolo importante nell’interpretazione del significato delle parole, delle frasi e dei concetti. Quando una persona apprende una nuova informazione, questa viene contestualizzata e integrata con quelle già esistenti, formando una rete di connessioni che definiscono la “comprensione” e il significato.

Confronto tra il processo nelle IA e negli esseri umani:

– Sistemi simbolici vs. connessioni neurali: Mentre le IA usano modelli numerici (ad esempio, vettori e matrici) per rappresentare le informazioni, gli esseri umani costruiscono una rappresentazione semantica che si fonde con esperienze sensoriali ed emotive. Le mappe mentali umane sono dinamiche, influenzate dalle esperienze, dalle emozioni e dalla consapevolezza.

– Comprensione cosciente: Gli esseri umani non solo archiviano informazioni, ma possiedono anche la capacità di riflettere, analizzare e creare significato in modo conscio. Le IA, invece, non hanno coscienza e non “comprendono” nel senso umano del termine. Esse si limitano a operare in base agli schemi e alle probabilità che sono stati addestrati su di esse.

– Apprendimento e adattamento: Gli esseri umani apprendono in modo molto più flessibile rispetto alle IA. La flessibilità cognitiva umana permette di adattarsi a nuove situazioni e di creare nuove connessioni in modo molto più creativo e complesso. Le IA, pur potendo adattarsi a nuovi dati, sono limitate dai set di dati con cui sono state addestrate.

In sintesi:

Nel caso delle reti neurali artificiali, la “sistemazione logico-semantica” avviene tramite l’apprendimento delle correlazioni tra i dati. Le informazioni vengono organizzate in vettori numerici che rappresentano concetti, ma senza una consapevolezza o un’esperienza cosciente. Gli esseri umani, al contrario, creano mappe mentali attraverso esperienze sensoriali ed emotive, associando concetti a significati consapevoli e a esperienze vissute. La differenza fondamentale è che mentre l’IA “comprende” in base a modelli statistici, l’essere umano costruisce una rete complessa di conoscenza che è legata alla percezione conscia del mondo e alle esperienze individuali.

Domanda: Ma questi vettori numerici di comprensione dove e come vengono conservati

In un certo senso, i pesi aggiornati nel processo di addestramento rappresentano una memoria a lungo termine del modello, poiché contengono la “conoscenza” che il modello ha acquisito durante l’addestramento.

Vantaggi della memoria distribuita:

La grande differenza tra il funzionamento delle IA e il cervello umano sta nel fatto che le IA non conservano informazioni esplicite su una singola memoria centrale (come la memoria umana), ma attraverso una memoria distribuita nelle connessioni della rete. Ogni parte della rete contribuisce a una “comprensione” collettiva, ma in maniera statistica e non cosciente.

Risultato finale:

La rete non “conosce” i concetti nel modo in cui lo fa un essere umano, ma piuttosto crea una rappresentazione matematica dei concetti attraverso le relazioni tra i dati che elabora.

In sintesi, mentre gli esseri umani creano mappe mentali che sono legate a esperienze consce e a strutture cerebrali, le reti neurali artificiali creano rappresentazioni numeriche distribuite delle informazioni, che vengono utilizzate per fare previsioni o generare output senza una “comprensione” conscia o esperienziale.

Domanda: In realtà mi dici che la comprensione in un modello IA è data dall’algoritmo in cui i pesi delle connessioni sono stati fino a quel punto aggiornati.

Ma facciamo un esempio pratico , io dico :

il cane abbaia ,il gatto miagola, la terra è piatta, il cuore forse batte.

L’algoritmo deve creare tante nuove connessioni con pesi nuovi diversi e quindi come salva la comprensione pregressa.

Hai sollevato una questione molto interessante! In un modello di intelligenza artificiale, la “comprensione” non è un processo che avviene come nella mente umana, in cui l’apprendimento è direttamente collegato a esperienze coscienti e ricordi. Tuttavia, il modo in cui una rete neurale “salva” la comprensione e si aggiorna per riflettere nuovi concetti è legato al modo in cui i pesi delle connessioni vengono modificati durante il processo di addestramento e, successivamente, durante l’inferenza (quando il modello è utilizzato per rispondere a nuove domande).

Facciamo un esempio pratico e vediamo come la rete neurale si comporta in relazione alla “comprensione” di frasi come quelle che hai menzionato.

Esempio Pratico

Immagina di addestrare una rete neurale a comprendere frasi come:

1. “Il cane abbaia.”

2. “Il gatto mialoga.”

3. “La terra è piatta.”

4. “Il cuore forse batte.”

Queste frasi contengono informazioni diverse, e in particolare, alcune di esse sono in contrasto con conoscenze generalmente accettate (come “la terra è piatta”). Ora, per spiegare come un modello come GPT o BERT affronterebbe queste frasi, vediamo il processo in due fasi: durante l’addestramento e durante l’inferenza.

Nel caso delle frasi che hai dato:

– Quando il modello vede frasi come “Il cane abbaia” e “Il gatto miagola”, il modello impara che “cane” e “abbaia” sono associati, così come “gatto” e “miagola”. La rete crea dei vettori numerici per ogni concetto, e le relazioni tra “cane” e “abbaiare” e tra “gatto” e “miagolare” sono apprese durante l’addestramento.

– Quando il modello legge frasi come “La terra è piatta”, l’algoritmo potrebbe imparare che, in base ai dati a cui è stato esposto, “terra” e “piatta” possono essere associati. Tuttavia, grazie alla vasta quantità di dati di addestramento, il modello può anche imparare che la maggior parte delle fonti scientifiche descrivono la terra come sferica, e quindi l’associazione di “terra” con “piatta” verrà pesata come meno forte.

– La frase “Il cuore forse batte” contiene un’incertezza che potrebbe far scattare un meccanismo di probabilità o di incertezza nel modello, ma ancora una volta, il modello potrebbe apprendere che “cuore” è spesso associato a “battito” nei dati di addestramento.

Ogni volta che il modello vede nuove frasi, i pesi vengono aggiornati per riflettere meglio la nuova connessione tra le parole e i concetti, ma questi aggiornamenti non distruggono le connessioni precedenti. Piuttosto, le nuove informazioni vanno a modificare l’intensità di alcune connessioni esistenti. La rete neurale non dimentica la comprensione precedente, ma la modifica leggermente per adattarsi alle nuove informazioni.

Fase 2: Durante l’Inferenza (Quando il modello genera risposte)

Una volta addestrato, il modello può essere utilizzato per rispondere a nuove frasi. Quando gli dici “Il cane abbaia” e gli chiedi una risposta, il modello risponde sulla base dei vettori numerici appresi durante l’addestramento. Questi vettori numerici contengono le connessioni tra parole e significati (ad esempio, l’associazione tra “cane” e “abbaiare”).

Nel caso di una frase come “La terra è piatta”, il modello risponderà cercando di mantenere coerenza con le sue conoscenze pregresse. Potrebbe generare una risposta che prende in considerazione sia i dati precedenti che quelli nuovi, per esempio dicendo qualcosa come: “La maggior parte degli scienziati concordano sul fatto che la terra sia sferica, ma alcune teorie sostengono il contrario.” In questo caso, il modello compensa la conoscenza errata che può essere presente in quella frase con la conoscenza più robusta e generalizzata che ha appreso.

Come “salva” la comprensione pregressa?

La comprensione pregressa viene salvata nei pesi della rete. Questi pesi sono quelli che il modello ha appreso durante il processo di addestramento e che sono congelati durante l’inferenza (cioè, non vengono modificati durante l’uso del modello).

Ogni connessione tra i neuroni della rete neurale rappresenta una relazione appresa durante l’addestramento, e quindi questi pesi sono responsabili del mantenimento delle informazioni apprese.

Domanda: Quindi esiste un solo enorme algoritmo che fotografa statisticamente la conoscenza e la comprensione della macchina sul mondo ?

Sì, in effetti si può considerare che, in un certo senso, un modello di intelligenza artificiale come GPT (o modelli simili) operi come un enorme algoritmo che “fotografa” la conoscenza e la comprensione del mondo. Tuttavia, va notato che questo non significa che il modello “comprenda” il mondo nello stesso modo in cui lo farebbe un essere umano, ma piuttosto che è in grado di riconoscere schemi, correlazioni e strutture linguistiche che emergono da miliardi di dati testuali a cui è stato esposto durante l’addestramento.

In sostanza, sì, esiste un algoritmo che fotografa in modo statistico e probabilistico la conoscenza e la comprensione che la macchina ha del mondo, ma questo processo è relazionale e dinamico, non statico come una raccolta di fatti. La rete neurale, attraverso l’aggiornamento dei pesi e la generalizzazione, è in grado di rispondere e adattarsi a nuove informazioni, mantenendo una certa coerenza con il contesto in cui opera.

Questo approccio non implica una vera e propria “comprensione” cosciente o “significato” nel senso umano, ma un calcolo avanzato di probabilità e correlazioni che permette alla macchina di interagire con gli esseri umani in modo che sembri “comprendere”.

Conclusioni generali dell’essere umano Peppe

In un articolo che scrissi nel 2020 sul mio blog , https://uomoetecnologia.com, affermavo :

La parola “CAPIRE” e, più in generale, “CAPIRSI” è il problema più importante che l’essere umano deve continuamente risolvere per sopravvivere sia come essere biologico che sociale.

E capirsi è una operazione, un processo, che sembra realizzarsi in questo dialogo fra me e la macchina.

Già il termine dialogo è inappropriato perché non avviene fra due persone eppure l’impressione, il sentimento, che emerge alla fine attraverso le mie domande e le risposte, quasi sempre molto articolate e tecniche, è spiazzante perché il dialogo non è banalmente bidimensionale e tiene conto, ancora in una forma rudimentale perché in parte ripetitiva, del già detto nella discussione in corso.

In realtà chi risponde è l’immenso universo del web in tutte le forme mediatiche che la storia, la cultura scritta, musicale, artistica nelle varie forme in cui si è smaterializzata e trasformata in bit ed è stata archiviata nel web.

Ma la cosa straordinaria è che la risposta è di per sé il risultato di una ricerca velocissima e piuttosto pertinente, fra quasi tutto il sapere umano codificato in bit.

E questo processo è dinamico nel senso che gli scenari descritti nelle risposte sono scelti , quando necessario, come nel caso di finanza, proponendo diverse alternative con relative probabilità.

Insomma la probabilità, sottesa o esplicita, è il sangue vitale che governa qualsiasi ragionamento della macchina, è il deus ex machina.

In questo c’è, nel bene e nel male, la divaricazione mentale con gli umani che vivono fondamentalmente di certezze e, con tutti i limiti legati al fatto che le certezze sono solo eventi che hanno, in un contesto personale e sociale, una probabilità soggettiva molto alta , rimane il fatto che le certezze sono lo scheletro del nostro “Essere nel mondo “.

Emerge infine la necessità di capire il ruolo che l’essere umano può avere in questa nuova relazione con la tecnica.

Così come con Copernico e Galileo si modificò la centralità della terra e di dio , così oggi si sta progressivamente spostando la centralità dell’uomo verso la macchina, in particolare verso la macchina dotata di Intelligenza artificiale .

Capire dunque in profondità e per quanto possibile tutti gli aspetti, tecnici e culturali, di tale processo risulta essere una necessità di “sopravvivenza” poiché oggi, come non mai, le conseguenze delle scelte tecniche sopravanzano la nostra capacità di prevedere le conseguenze delle nostre scelte.

Quindi il rischio è di rimanere prigionieri di un destino in cui una ristretta e ricchissima oligarchia decide per tutti noi e non semplicemente privandoci della libertà ma convincendoci profondamente e quindi emotivamente della necessità e bontà di tali scelte.

È evidente che nessuna prospettiva di salute e di sopravvivenza potrà fare a meno della scienza e della tecnica ma rimane sempre la necessità che al centro ci sia l’uomo ed è in questo senso che occorre un UMANESIMO TECNOLOGICO.

Qualche osservazione in ordine sparso:

Da quel poco che capisco, l’esperimento di Searl è “tranchant”, nel senso che se siamo convinti, come io sono, che Searl abbia ragione, l’affermazione:

“La persona all’interno della sala non comprende il cinese, ma può seguire le istruzioni nel libro per associare simboli in cinese con altre risposte in cinese. Essenzialmente, la persona sta “traducendo” le risposte senza alcuna comprensione del significato”

per me chiude la questione. Sposo totalmente la seguente affermazione della “scatola parlante” a proposito della interpretazione di Searl:

“Le IA, infatti, operano seguendo algoritmi predeterminati e non hanno esperienze soggettive. Anche le IA più avanzate, come quelle basate su reti neurali profonde, sono capaci di eseguire compiti che normalmente richiederebbero intelligenza umana, ma non possiedono la consapevolezza di sé o delle proprie azioni.”

Proprio in questo senso a me dà un grande fastidio, addirittura mi sembra una frode intellettuale, sentir dire: “l’IA ha prodotto un vaccino ….”; il modo corretto di dire sarebbe: servendosi di computers molto potenti le conoscenze acquisite dalla intelligenza umana hanno consentito di produrre …”. Sarebbe come dire: “il treno mi ha fatto andare a Milano in poche ore” invece di dire: “ho deciso di andare a Milano e ho preso un terno AV che arriva a Milano in poche ore”.

Quanto alla questione che

“la coscienza di sé è fondamentalmente la “proiezione” del corpo che viene in un certo senso ” mappato” nel cervello”,

non concordo pienamente, perché questa affermazione presuppone una separatezza tra mente e corpo: io invece credo che la mente sia una parte del corpo, e non ha quindi senso dire che una parte del corpo crea una mappa di un’altra parte della stessa cosa. D’altra parte, andando avanti con la lettura, scopro che già la teoria dell’embodiment sostiene che la mente non sia separata dal corpo, ma che

“lanostra esperienza mentale sia radicata nelle esperienze fisiche del corpo.”

Un altro dubbio mi solleva l’affermazione della “scatola parlante” L’idea che

“la quantità, superata una certa soglia, diventi una qualità è strettamente legata al concetto di emergenza, che si riferisce al fenomeno in cui un sistema complesso, composto da molteplici componenti:”

Credo che qui ci sia una sbagliata interpretazione del concetto di complessità (chiedere a Giorgio Parisi per ragguagli), che invece, nella sua accezione fisica originale (teorema di Liapunov e attrattore strano) non riguarda il fatto che il processo che segue l’evoluzione di un sistema sia più o meno lunga e complicata, quanto il fatto che, pur essendo l’evoluzione deterministicamente prevedibile sulla base di leggi fisiche, la traiettoria nello spazio delle fasi è così fortemente condizionata dalla condizioni iniziali che il risultato finale cambia drasticamente e viene definito caotico (vedi la farfalla in brasile che determina con un battito di ali un tornado a New York). Esistono certamente in Fisica fenomeni che sono governati da “soglie”, nel senso che il superamento di un valore critico da parte di una variabile può determinare esiti molto diversi rispetto a quelli che corrispondono a valori inferiori (basta pensare ad una reazione nucleare che può avvenire solo se l’energia incidente supera la soglia di emissione a causa dell’energia di legame della particela emessa), ma la “virata” da un comportamento ad un altro va vista come l’innesco del superamento del limite di validità du un altro fenomeno associato. Non credo quindi che, come affermato da CHAT:

“A un certo punto, l’aumento della complessità e della connettività neuronale potrebbe aver portato a una soglia critica in cui le funzioni cognitive superiori sono emerse in modo qualitativamente nuovo”

“Esattamente, il tuo pensiero è molto interessante e in effetti rappresenta uno dei temi centrali delle discussioni moderne sull’intelligenza artificiale (IA) e la coscienza.”:

a parte che mi pare che la scatola sia piuttosto ruffiana, non lesinando complimenti all’astuzia delle domande, io non credo (ma ovviamente posso sbagliarmi) che se riuscissimo a costruire una rete neurale artificiale abbastanza complessa e sofisticata, essa potrebbe, in teoria, sviluppare una forma di coscienza o autoconsapevolezza

“In termodinamica, l’energia libera di un sistema è la quantità di lavoro macroscopico che il sistema può compiere sull’ambiente

– Energia libera: Il termine “energia libera” in questo contesto è diverso e si riferisce all’incertezza o alla sorpresa che un sistema ha riguardo al suo ambiente. Se un sistema (come il cervello) è in grado di prevedere correttamente gli input sensoriali che riceve, questa incertezza (o energia libera) sarà bassa. Quando le previsioni sono sbagliate o quando c’è confusione, l’energia libera aumenta”.

Ecco appunto: il povero Gibbs non sarebbe contento dell’uso che si fa in questo ambito della variabile che ha introdotto.

Un altro punto fondamentale della teoria di Seth è che

“la coscienza può essere vista come un processo di inferenza probabilistica”

.: in Fisica, l’inferenza è uno dei due pilastri alla base del metodo scientifico di Galileo: “… pare che quello degli effetti naturali che la sensata esperienza ci pone dinanzi agli occhi o le necessarie dimostrazioni ci concludono, non debba in conto alcuno esser revocato in dubbio.” Galileo Galilei

Un altro aspetto interessante del lavoro di Seth riguarda la possibilità di applicare questi concetti anche alla coscienza nelle macchine.

“Se una macchina fosse in grado di ridurre l’incertezza e fare previsioni sul suo ambiente e sul suo stato, potrebbe teoricamente essere cosciente.”

Su questa affermazione dissento totalmente: direi che la capacità della macchina di ridurre l’incertezza delle sue previsioni è già, per la legge dei grandi numeri, quasi al suo grado massimo ed un suo eventuale aumento non cambierebbe di fatto un aspetto di cui sono persuaso: le nostre inferenze (di nuovo Galileo) sono basate su quantità molto limitate di dati e perciò sono fallibili; la scienza ne è perfettamente consapevole ed usa il concetto di “errore sperimentale” per rendere quantitativo il grado di incertezza e limitare il campo di validità delle sue previsioni. Osservazioni più precise possono falsificare teorie fino a prima accettate (vedi la dinamica di Newton e la relatività ristretta), ma solo nel senso che queste ultime costituivano una approssimazione della teoria successiva, valida soltanto “entro gli errori sperimentali”. Il processo scientifico di costruzione della conoscenza continua ad innalzare mattone per mattone l’edificio della conoscenza, anche grazie al fatto che i cosiddetti giganti erano in realtà nani che vedevano lontano grazie al fatto che stavano sulle spalle di un gigante.

Infine la teoria “fisica” della coscienza: ci sono altri esempi di tentativi di estensione del significato di grandezze fisiche in altri ambiti (vedi l’entropia nelle teorie economiche e simili), ma dimenticano tutti che uno dei pilastri dell’edificio della conoscenza è quella che va sotto il nome di “DEFINIZIONE OPERATIVA DI UNA GRANDEZZA FISICA”, che presuppone l’identificazione di un rigoroso procedimento che uda uno strumento di misura per associare un valore numerico nelle opportune unità ad una grandezza. Certamente l’entropia ha un ruolo nel determinare l’evoluzione di processi biologici (abbiamo recentemente parlato di Gellman e Prigogine) e nel porre vincoli precisi sulla freccia del tempo. Io però diffido dei tentativi, effettuati anche da grandi pensatori di altri campi del sapere rispetto alla fisica, di estendere arbitrariamente cncetti rigorosi per tentare di piegarli a dimostrare le loro teorie.

Rimango comunque dell’idea che la cosiddetta AI non può che riprodurre fedelmente vizi e virtù della marea di roba, parte buona parte schifezza, che noi umani abbiamo messo sul WEB Non a caso tutti i processi decisionali affidati all’aAI nella società attuale soffrono delle stesse discriminazioni di cui soffre l’attività umana ed il loro uso indiscriminato ci sta portando inesorabilmente alla dittatura della sorveglianza.

"Mi piace""Mi piace"

Caro Filippo

Mi fa molto piacere che aggiungi le tue valide osservazioni al mio “dialogo” con GPT.

E ,se leggi le mie conclusioni finali devi riconoscere che anche io sono della convinzione che siamo lontanissimi dalla macchina “pensante”.

Io ho letto diversi autori, non filosofi, e mi sono convinto che il cervello elabora quello che chiamiamo mente attraverso un continuo feedback tra il modello interno di conoscenza pregresso ed i dati sensoriali che riceve e quindi una intelligenza che non SENTE il corpo non è capace di essere COSCIENTE.

Mi colpisce invece positivamente l’ipotesi che proprio questo processo permette un continuo “aggiornamento ” del modello di RAPPRESENTAZIONE della realtà che noi abbiamo e questo sia su dati fisici che su dati emotivi.

L’ipotesi del cervello predittivo è ormai largamente accettato in neurologia.

Sul meccanismo che la coscienza è la “gestione” di questa “differenza” sono come fisico dubbioso perché mancano studi SPERIMENTALI a supporto ma già sto chiedendo a GPT se mi può fornire fatti e dati in questo senso.

Innegabilmente la teoria FEP è interessante.

"Mi piace""Mi piace"

Grazie per questo articolo che ci porta dentro il mondo dell’IA in maniera molto dettagliata.

Riguardo ai neuroni specchio, mi ricordo di aver letto altrove che forse la loro importanza per lo sviluppo dell’empatia, ecc, era stata esagerata inizialmente.

L’idea di una IA che risponde alle emozioni umane in maniera ‘corretta’ sarà già parzialmente in essere, o comunque immagino si potrà fare. Una macchina così sarà una specie di sociopatico o psicopatico, nel senso che potrà manipolare le ns emozioni senza provare nulla. (Tipo immagino Elon Musk!) Forse potranno essere psicopatici benigni, in base ai compiti che ricevono da chi li controlla. Certo preoccupa non poco!

Forse uno dei problemi di queste macchine è che possono si’, ‘pensare’, attività che si può modellare con circuiti elettrici perchè anche i ns neuroni funzionano con gli impulsi elettrici. Ma le emozioni, se non sbaglio, utilizzano anche la chimica (gli ormoni, ecc)…forse questa è una differenza.

L’argomento mi fa venire in mente Umberto Galimberti che diceva che la tecnica non ha altro scopo se non propagare e aumentare se stessa. Fa le cose perchè le può fare ma non perchè servono o ci fanno bene. (A parte alcuni utilizzi benefici). Ma siamo qui. Stiamo eliminando noi stessi!

"Mi piace""Mi piace"